Hadoop es un framework diseñado para el desarrollo de aplicaciones distribuidas, enfocado en la gestión eficiente de grandes volúmenes de datos. El uso de Hadoop puede verse limitado por los elevados costes asociados al mantenimiento y la gestión de administradores de sistemas, lo que ralentiza el desarrollo y la implementación de soluciones.

Además, los sistemas de almacenamiento masivo on-premise presentan limitaciones significativas para realizar análisis avanzados de datos. Estas restricciones obligan a muchas organizaciones a formar y contratar equipos especializados en analítica avanzada, incrementando la complejidad operativa y reduciendo la eficiencia y el valor generado.

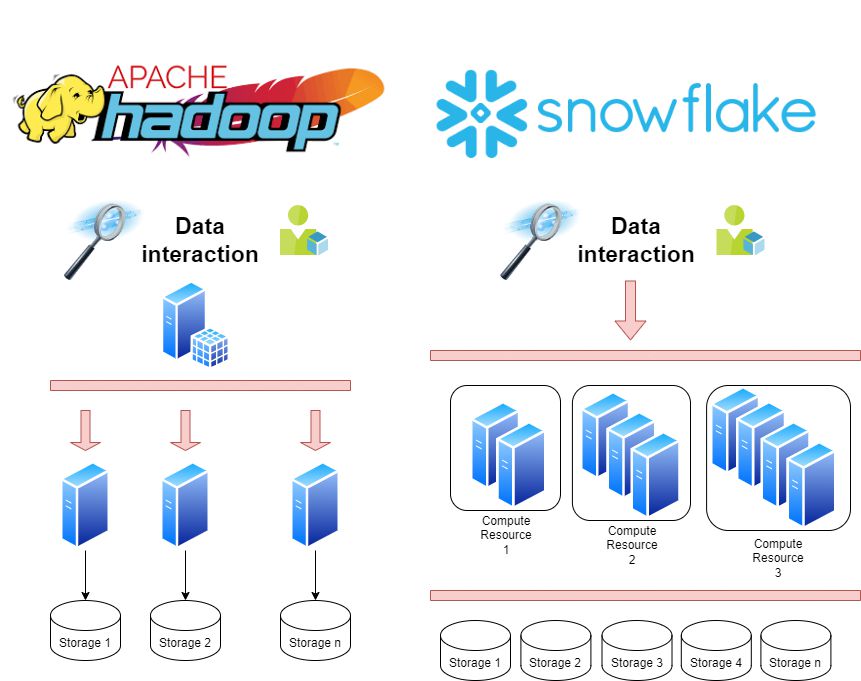

En contraste, la arquitectura de datos en la nube de Snowflake simplifica la gestión de datos, facilita la analítica avanzada y fortalece el gobierno y la calidad de los datos en un entorno centralizado. Esta solución aborda de manera integral los desafíos más comunes de los sistemas on-premise.

La arquitectura data cloud combina todas las capacidades necesarias para gobernar, procesar y analizar datos de manera unificada, optimizando así los procesos y mejorando el rendimiento general de las organizaciones.

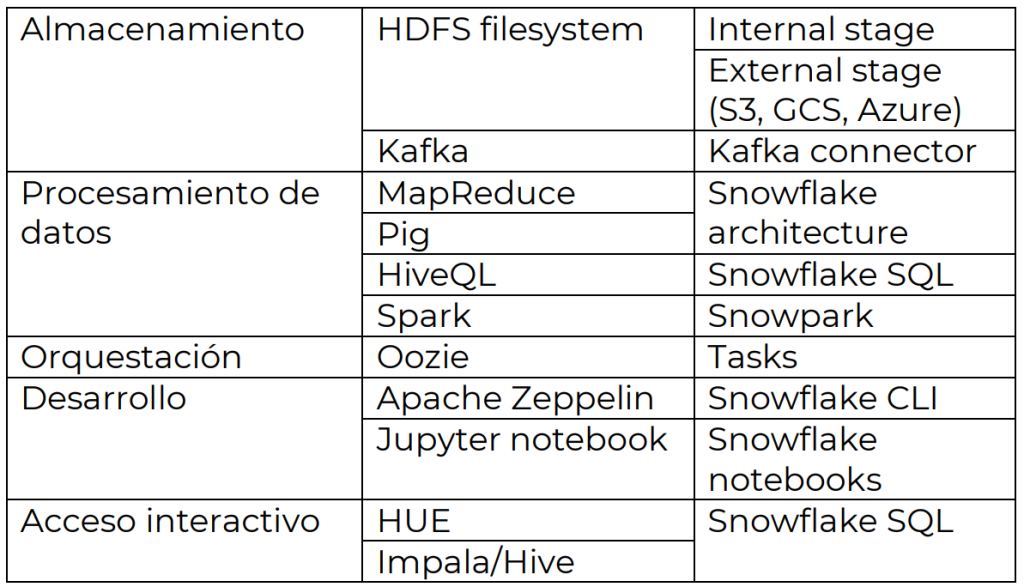

Veamos una comparativa de los diferentes componentes de Hadoop y cómo se relacionan con Snowflake.

Ventajas de migrar a Snowflake en tu organización

- Todo el servicio está centralizado en un único sitio web, acelerando los procesos de desarrollo y mejorando la user experience.

- Snowflake encripta por defecto todos los datos. Así, mejora la seguridad de los datos y ofrece una capacidad de perfilado en grano fino para roles de seguridad y capacidad de auditoría avanzada.

- Al ser un servicio en la nube, Snowflake no requiere de mantenimiento ni actualización por parte del usuario, mientras que Hadoop requiere actualizaciones manuales y mantenimiento recurrente, lo cual implica tiempos de espera mayores y la necesidad de personal de sistemas.

- Snowflake separa computación y almacenamiento. Esta capacidad simplifica el escalado, a la vez que resulta más rentable ya que solo se paga el espacio utilizado.

- En Snowflake, puedes utilizar una serie de conectores hacia otros sistemas de almacenamiento, facilitando el gobierno de datos en tu organización.

- Con las múltiples capacidades de IA generativa, permite realizar consultas de datos en lenguaje natural con capacidad simple de integración con otras aplicaciones como Streamlit.

Procedimiento de migración de Hadoop a Snowflake

La migración de Hadoop a Snowflake implica una serie de hitos clave que deben gestionarse cuidadosamente para garantizar el éxito del proceso. Estos hitos incluyen:

1. Evaluación de los componentes

- Analiza los datos y procesos existentes en Hadoop, identificando oportunidades para centralizarlos y simplificarlos en Snowflake.

- Evalúa los datos almacenados, como tablas en formato parquet y tablas de enriquecimiento, así como los flujos de procesos, como ETL con Apache Oozie y procesamiento continuo con Spark Structured Streaming.

- Revisa las herramientas de monitoreo y consumo de datos, como Cloudera Resource Manager, Apache Zeppelin y PowerBI, para planificar su integración en Snowflake.

2. Movimiento de datos

- Traslada las tablas de ventas anuales desde Hadoop a un sistema de almacenamiento como S3, Azure o GCP usando herramientas como distcp.

- Crea un external stage en Snowflake con las credenciales y formatos necesarios.

- Replica la estructura de las tablas en Snowflake y utiliza COPY INTO para importar los datos.

3. Migración de workflows

- Planifica la descarga de datos mediante tasks en Snowflake, creando funciones externas para llamar a las APIs y actualizar las tablas.

- Configura un conector de Kafka para manejar el flujo de datos en tiempo real, creando tablas bronce y transformándolas con tasks y streams.

- Usa Snowpark y notebooks para procesar datos y ejecutar análisis avanzados.

- Conecta herramientas como Power BI y Streamlit para consumir y visualizar los datos.

4. Evaluación del proceso

- Monitorea el entorno en Snowflake para analizar el historial de ejecuciones, los costos de uso, las alertas y la seguridad.

- Evalúa la mejora en costes, eficiencia operativa, calidad de datos y tiempos de procesamiento para validar el éxito de la migración.

En hiberus somos Service Partner Select de Snowflake y contamos con un equipo certificado en la plataforma que tiene una gran experiencia en el desarrollo de estrategias de datos. Podemos ayudarte a diseñar, migrar, implantar y sacar el máximo partido de las soluciones Snowflake más adecuadas para tu negocio. ¿Hablamos?

¿Quieres más información sobre nuestros servicios de Snowflake?

Contacta con nuestro equipo de Snowflake